Retrieval-Augmented Generation: Kontext ist König — Wissen gezielt nutzen, Antworten präzise generieren

Retrieval-Augmented Generation (RAG) soll aus herkömmlichen KI-Sprachmodellen kontextgenaue Assistenten für den Arbeitsalltag machen. Wie das genau funktioniert, erklärt der Bundesverband Digitale Wirtschaft (BVDW) e. V. im Whitepaper „Retrieval-Augmented Generation: Wissen gezielt nutzen, Antworten präzise generieren“.

RAG individualisiert LLMs

KI-basierte Sprachmodelle (Large Language Models, LLMs) sind zu einer echten Stütze in der Arbeitswelt geworden. Sie strukturieren Informationen, automatisieren Prozesse und sind kreativer Sparringspartner. Standard-LLMs basieren dabei in der Regel nicht auf unternehmensspezifischen Trainingsdaten und haben keinen direkten Zugriff auf interne Wissensbestände. So bleiben ihre Ergebnisse häufig allgemein.

Genau hier setzt Retrieval-Augmented Generation an. Es ist ein KI-Ansatz, bei dem ein LLM auf Unternehmensquellen zurückgreift. Unternehmen reichern das RAG-System mit ihren Informationen an und erhalten so fachlich präzise und kontextgenaue Antworten. Sie behalten dabei die volle Kontrolle über ihre Daten und die generierten Ausgaben. RAG-Architekturen lassen sich plattformübergreifend kombinieren.

© Bundesverband Digitale Wirtschaft, Ressort KI, November 2025

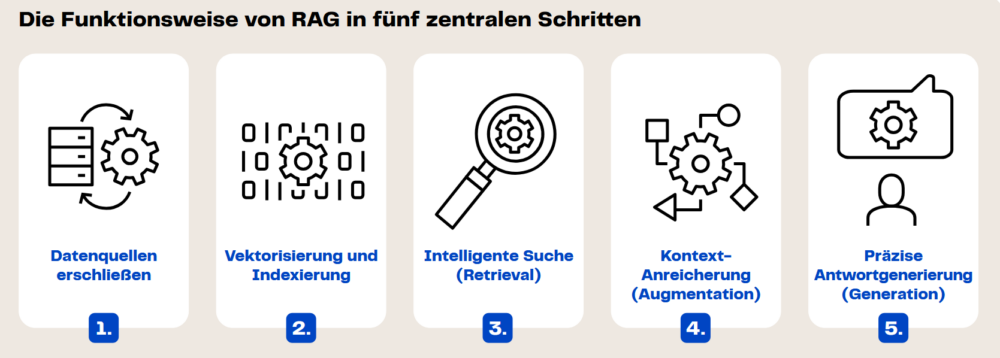

- Datenquellen erschließen: Unternehmen definieren, welche Informationen an das RAG-System angebunden werden. Sie behalten vollständigdie Datenhoheit.

- Vektorisierung und Indexierung: Das System wandelt die Inhalte in semantische Vektoren um und legt diese in einer Vektordatenbank ab. So lassen sich ähnliche Informationen leichter finden.

- Intelligente Suche (Retrieval): Bei einer Anfrage durchsucht das RAG-System diese Datenbank nach relevanten Informationen – nicht über Keywords, sondern über Bedeutungsähnlichkeiten.

- Kontext-Anreicherung (Augmentation): Die gefundenen Textabschnitte werden dem LLM automatisch als zusätzlicher Kontext übergeben.

- Präzise Antwortgenerierung (Generation): In der Ausgabe kombiniert das Modell die Sprachkompetenz des LLMs mit spezifischem Wissen aus dem Unternehmen. Es liefert individuelle Antworten, ohne aufwendiges Training.

RAG erfordert eine klare Informationsstruktur

Das Whitepaper des BVDW zeigt: Unternehmen profitieren in unterschiedlichen Bereichen von RAG. Im Wissensmanagement unterstützt das System durch detaillierte Übersichten interner Informationen. Im Support lassen sich Produktdokumentationen aufschlüsseln und automatisch in präzise Service-Antworten fassen. Zudem stärken RAG-Prozesse Compliance und Entscheidungsqualität: Rechtliche Vorgaben und Formulierungen lassen sich nicht nur finden, sondern auch interpretieren – inklusive nachvollziehbarer Quellen.

Damit Unternehmen diese Vorteile nutzen können, brauchen sie eine saubere Datenbasis. Wenn Informationen unklar oder widersprüchlich strukturiert sind, kann die Qualität der Ergebnisse stark darunter leiden. Gleichzeitig betonen die Autor*innen, dass der Umgang mit sensiblen Unternehmensinterna Governance- und Sicherheitskonzepte erfordert. Sie gewährleisten die Konsistenz interner Informationen sowie Datenschutz und Systemstabilität.

Ein neuer Reifegrad generativer KI

RAG rückt KI-Sprachmodelle näher an die Realität von Unternehmen und gestaltet den Einsatz von KI zunehmend geschäftsrelevant. Die Kombination aus kreativer Exzellenz und fachlich belastbaren Antworten verbessert die Qualität von operativen und strategischen Entscheidungen. Langfristig entsteht so eine neue Form datengetriebener Wertschöpfung – individuell, zielorientiert, technologiegetrieben. Investieren Unternehmen frühzeitig in RAG, können sie sich relevante Wettbewerbsvorteile erschließen